KI mit Lokaler Ollama und WebUi

Lesezeit: 10-15 Minuten Stufe: Einsteiger bis Fortgeschrittener Anfänger Vorkenntnisse: Basiswissen aus Teil 1 (Ollama lokal) empfohlen Kosten: 0€ (Open Source)

🖥️ Lokale KI ganz einfach mit WebUI – dein smarter Einstieg

Im letzten Beitrag haben wir gesehen, wie einfach es ist, Ollama als lokale KI auf dem eigenen Rechner einzurichten – ohne Cloud, ohne Kosten, aber mit voller Kontrolle. Jetzt gehen wir den nächsten Schritt:

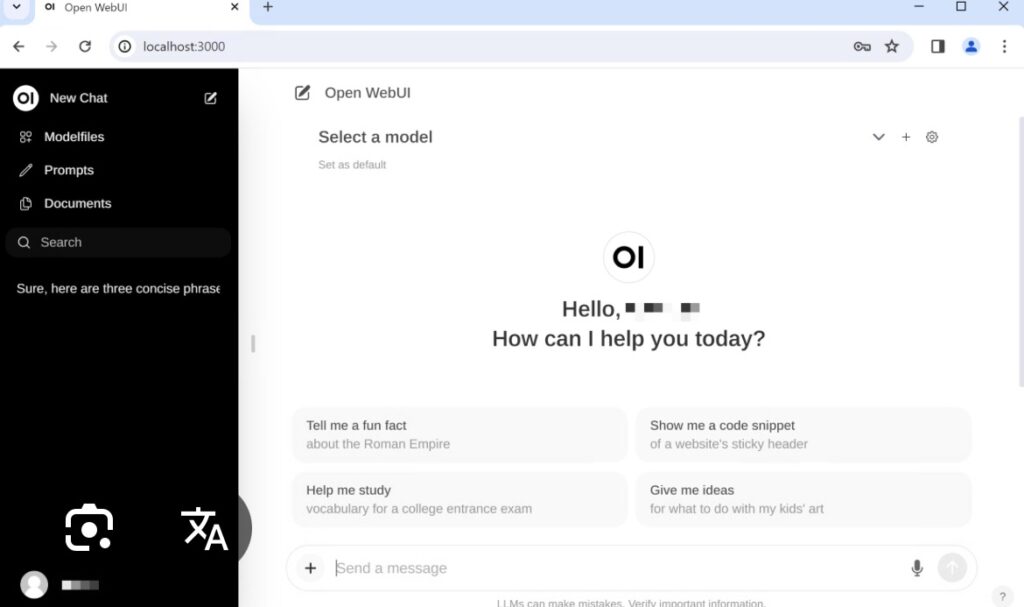

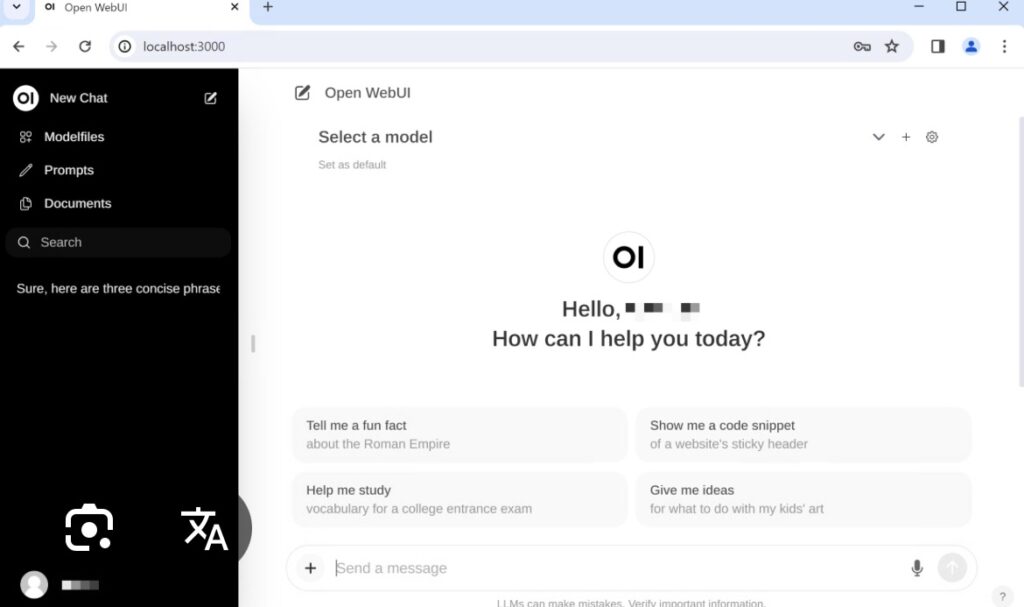

Mit WebUI bekommt deine KI ein Gesicht – und du ein grafisches Bedienfeld, ganz ohne Kommandozeile. Egal ob für den Alltag, zum Spielen oder für kleine Automatisierungen: WebUI macht alles einfacher und zugänglicher.

🚀 Warum WebUI?

- Einfach zu bedienen: Kein Terminal, keine Codes – einfach im Browser chatten.

- Visuelle Verwaltung: Modell-Auswahl, Verlauf, Rollenprofile – alles per Klick.

- Erweiterbar: Später mit Dateien, Plugins und sogar Zugriff auf deine eigenen Daten erweiterbar.

🔧 Installation: Ollama + WebUI

Voraussetzung: Du hast Ollama bereits installiert (siehe Teil 1 ).

Nun installieren wir WebUI. Am einfachsten geht das per Docker:

docker run -d \

-p 3000:3000 \

-e 'OLLAMA_HOST=http://host.docker.internal:11434' \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webuiNach ein paar Sekunden erreichst du deine eigene Oberfläche unter:

http://localhost:3000

🧭 Erste Schritte in der WebUI

- Modell starten: Wähle z. B.

llama3odermistralaus der Liste. - Chat beginnen: Schreibe direkt in das Textfeld – wie bei ChatGPT.

- Rollenprofile: Erstelle z. B. einen Schreibassistenten, IT-Support oder Ideengeber.

🔮 Was du mit WebUI noch alles machen kannst

Sobald deine WebUI steht, kannst du mit wenigen Handgriffen tiefer eintauchen – und dein System Stück für Stück erweitern. Hier ein kleiner Ausblick:

🧠 Eigenes Modeling

Du kannst mit Custom Prompts oder benutzerdefinierten Rollen arbeiten – sogar mit verschiedenen Personas für unterschiedliche Aufgaben. Wer will, kann auch eigene Modelle über Ollama integrieren.

🔁 Automatisierung mit n8n

Mit n8n kannst du deine lokale KI automatisieren. Beispiele:

- Telegram-Bot mit lokaler Intelligenz

- Texte aus PDFs extrahieren und zusammenfassen

- Regelmäßig Webseiteninhalte analysieren lassen

📚 RAG oder Datenbank als KI-Gedächtnis

Mit RAG (Retrieval-Augmented Generation) verbindest du deine KI mit echten Wissensquellen. Die KI kann dann aus deinen PDFs, Notizen oder Datenbanken lernen – und echte, datenbasierte Antworten geben.

✅ Fazit

Mit Ollama + WebUI holst du dir nicht nur eine KI auf den eigenen Rechner – du schaffst dir ein kleines KI-Studio für Alltag, Hobby oder Business. Datenschutz bleibt bei dir, keine Abo-Kosten, keine Limitierungen durch Cloud-Anbieter.

Der Einstieg ist einfach – und der Weg nach oben ist offen: Automatisieren, Lernen, Gestalten. Alles lokal, alles selbstbestimmt.

🔗 Quellen & Tools

Du willst mehr? In Kürze folgt Teil 3 mit konkreten Praxisbeispielen zur Automatisierung mit KI und n8n!