Deine eigene KI mit Ollama – lokal, günstig, machbar

Lesezeit ca: 15 Minuten

Stufe: Anfänger

Umsetzung ca: 30 Minuten (bei Bedarf einiges an Übungszeit)

Kosten : 0€

mit KI Unterstützung erstellt

Einfach erklärt: Deine eigene KI mit Ollama – lokal, günstig, machbar

Du hast von Künstlicher Intelligenz (KI) gehört – ChatGPT, Midjourney, Copilot und Co. – aber fragst dich: Kann ich das auch selbst nutzen, ohne gleich in die Cloud-Welt abtauchen zu müssen?

Die gute Nachricht: Ja, das geht! Und mit einem Tool namens Ollama sogar erstaunlich einfach – und vor allem lokal auf deinem eigenen Rechner.

In diesem Artikel zeige ich dir einen sanften Einstieg in die Welt der lokalen KI. Ohne Buzzwords. Ohne Vorwissen. Und mit einem klaren Ziel: Selbst machen statt nur staunen.

🧠 Was ist Ollama überhaupt?

Ollama ist eine Open-Source-Software, die es dir ermöglicht, Sprachmodelle wie ChatGPT auf deinem eigenen PC oder Server laufen zu lassen – ganz ohne Cloud-Zwang. Das bedeutet: Deine Daten bleiben bei dir. Keine Registrierung, keine Abo-Kosten, keine Datenspuren im Netz.

🔒 Warum lokale KI? 3 starke Vorteile

- Datenschutz pur: Deine Eingaben verlassen nie deinen Rechner. Ideal für sensible Projekte oder persönliche Notizen.

- Keine Internetverbindung nötig: Läuft komplett offline – ideal auch in Netzwerkschranken oder abgeschotteten Umgebungen.

- Einmalige Einrichtung – keine laufenden Kosten: Einmal installiert, kannst du so viele Modelle ausprobieren wie du möchtest – kostenlos.

💰 Was brauche ich? Low bis Mid-Budget Einstieg

Das Schöne an Ollama: Es läuft schon auf normaler Hardware. Hier eine grobe Einschätzung:

Wichtig: Auch ohne GPU funktioniert Ollama – nur eben etwas langsamer. Zum Start reicht ein normaler PC völlig aus.

⚙️ Erste Schritte: Grundkonfiguration

Ollama zu installieren ist überraschend einfach – hier ein Überblick:

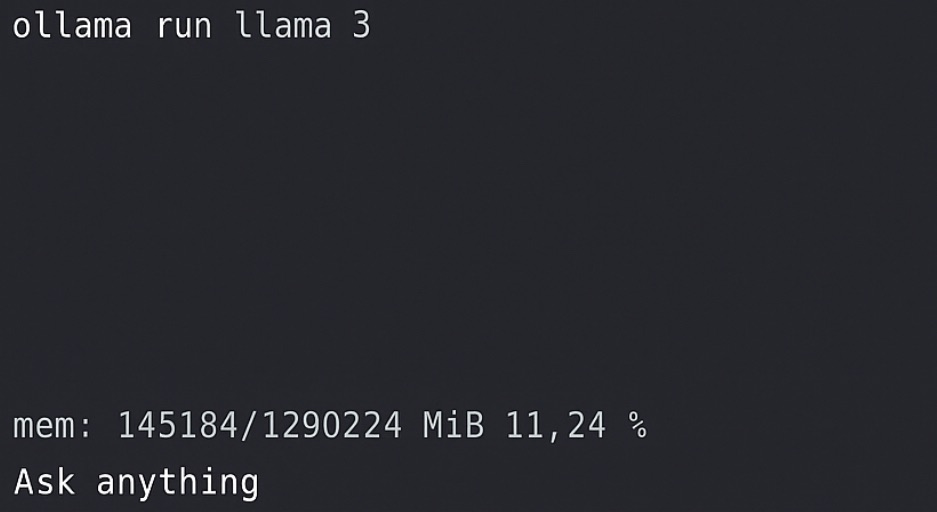

# Installation (Ubuntu/Linux):

curl -fsSL https://ollama.com/install.sh | sh

# Modell starten (Beispiel: llama3)

ollama run llama3Einmal installiert, kannst du direkt loslegen. Für Windows-User gibt’s auch einfache Docker-Setups oder WSL-Anleitungen.

🚀 Was kommt danach? Ausblick für Entdecker

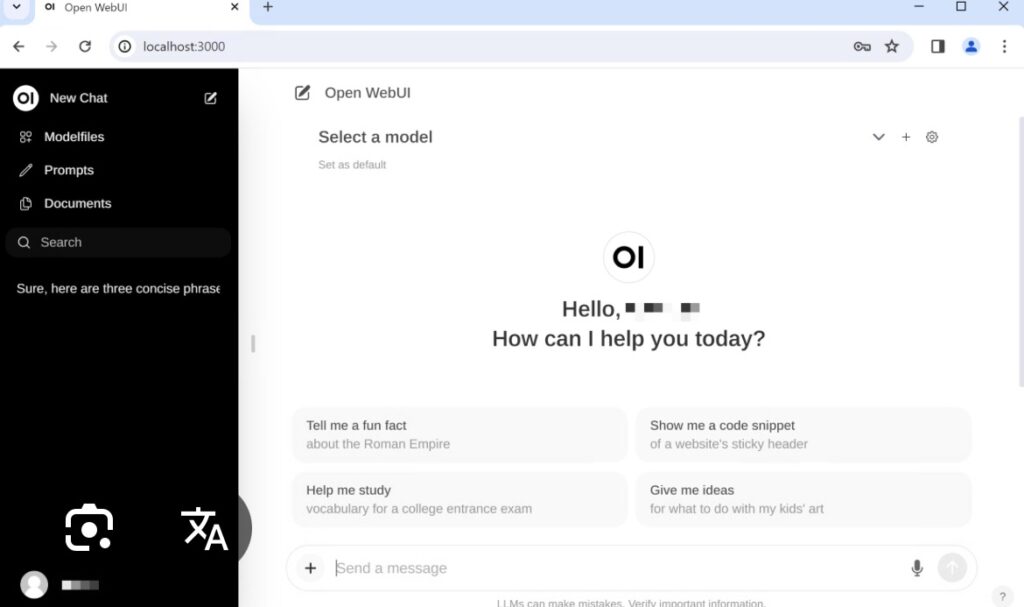

🌐 Web-Oberfläche: Open-WebUI

Mit dem kostenlosen Frontend Open-WebUI steuerst du deine lokale KI ganz bequem per Browser. Chatverläufe, Dateiuploads und mehr – alles lokal.

🧩 Eigene Modelle? Kein Problem!

Du kannst eigene Prompts, Rollen oder sogar komplett eigene Modelle erstellen. Praktisch, wenn du einen Assistenten mit Persönlichkeit brauchst – z. B. für Technik-Support, kreative Texte oder Lerninhalte.

🤖 Automatisieren mit n8n

Ollama lässt sich prima mit Tools wie n8n kombinieren. Damit kannst du:

- Automatisierte Antworten auf E-Mails erstellen

- Webseiteninhalte zusammenfassen

- Telegram-Bots mit KI-Intelligenz füttern

🧠 Gedächtnis: RAG & Datenbanken

RAG (Retrieval-Augmented Generation) ermöglicht es deiner KI, gezielt in eigenen Dateien oder Datenbanken zu suchen. So wird dein Chatbot zum Archiv-Profi und kann mit deinem echten Wissen arbeiten.

✅ Zusammenfassung

Ollama macht den Einstieg in lokale KI einfach, günstig und datenschutzfreundlich.

Für Einsteiger, Technikbegeisterte und alle, die selbst die Kontrolle behalten wollen. Du brauchst keinen Supercomputer – nur etwas Neugier und ein bisschen Bastel-Laune.

Und wenn du dranbleibst, kannst du dir nach und nach ein echtes KI-Ökosystem aufbauen: Mit Web-UI, Automatisierung und deinem eigenen Wissensspeicher.

🔗 Quellen & Tools

- Ollama – offizielle Webseite

- Open-WebUI – GitHub

- n8n – Automatisierungsplattform

- Llama3 – Meta AI Open Model

- RAG erklärt (HuggingFace)

In den nächsten Tagen und Wochen werde ich die in Ausblick gestellte Themen näher beschreiben.

Definiere „Anfänger“!

Dreimal gelesen und die Augen rollen immer noch.

Das Karussell in meinem Kopf, dreht immer noch.

Mir fehlt einfach die Karte, für die Orientierung. Einfach mal machen? Hm? Da steht etwas von „Installation (Ubuntu/Linux)“, heißt das: nicht für Linux Mint?

Hi,

Danke für deinen Kommentar.

Doch du kannst auch Linux Mint nehmen, dass ist möglich.

Ich nutze hier gerne immer nur ein Server System ohne GUI, da es Ressourcen schonender ist, aber möglich ist dies ohne Probleme.

Die Anleitung für andere Systeme findest du z.B. auch hier:

https://github-com.translate.goog/ollama/ollama?tab=readme-ov-file